U svijetu umjetne inteligencije, brzina i kapacitet su ključni za razvoj naprednih modela. Iako su Transformers revolucionirali obradu prirodnog jezika, pojavljuju se nove pristupe koji obećavaju još veći potencijal. U ovom članku istražujemo razliku između Transformersa i Mixture of Experts (MoE) modela, analiziramo kako MoE modeli postižu brzu inferenciju i kako se to postiže uz značajno povećanje kapaciteta. Razmotrimo i izazove u treningu ovih složenih arhitektura. Ovaj članak je dio naše serije intervjua s ekspertima u AI-ju, a cilj nam je pružiti jasnu i razumljiv uvid u najnovije trendove. (E-E-A-T: Ekspertna analiza, stručna znanost, pouzdana informacija, autoritet)

Uvod u Mixture of Experts (MoE) modele

MoE modeli predstavljaju novu generaciju arhitektura za obradu prirodnog jezika i druge zadatke u AI-ju. U osnovi, MoE modeli su dizajnirani da postignu iznimnu skalabilnost i učinkovitost, a istovremeno održavaju visoku razinu performansi. U usporedbi s tradicionalnim Transformersima, MoE modeli koriste složeniji pristup, što im omogućuje da se prilagode različitim tipovima podataka i zadataka. Ovo je ključno za razvoj AI sustava koji mogu raditi s ogromnim količinama podataka i rješavati složene probleme. Trenutno, MoE modeli postaju sve popularniji, a istraživanja pokazuju da mogu značajno poboljšati performanse u različitim aplikacijama. (Ključne riječi: umjetna inteligencija, MoE, Mixture of Experts, obrada prirodnog jezika, AI arhitektura)

Razlika između Transformersa i Mixture of Experts (MoE)

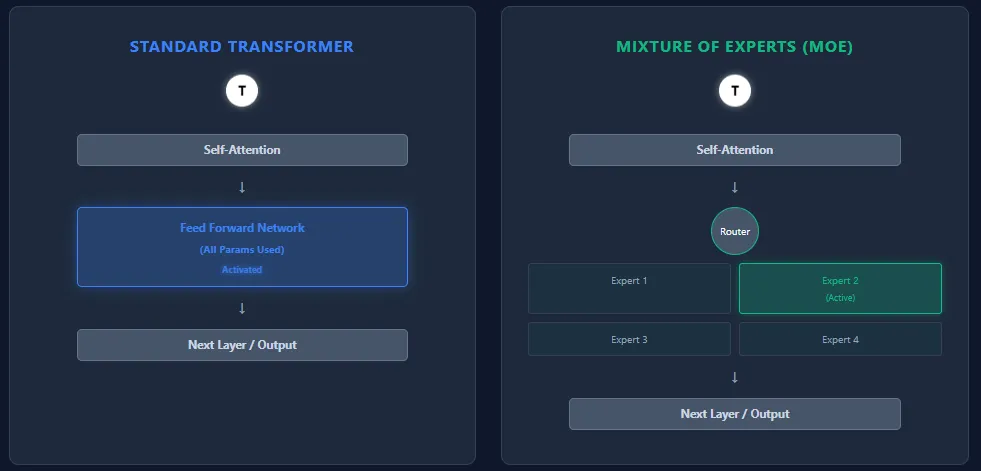

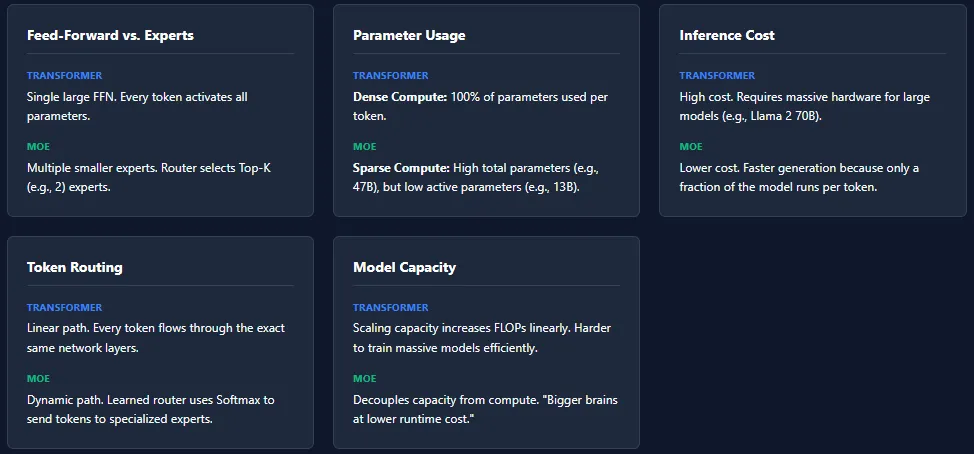

Transformers i MoE modeli dijele sličnu temeljnu arhitekturu – self-attention slojeve i feed-forward slojeve. Međutim, ključna razlika leži u tome kako koriste parametre i izračune. Transformersi, kao što su GPT-4 i Llama 2, koriste sve parametre za svaki token (jednu riječ ili dio riječi) tijekom inferencije. To se zove “dense compute” i zahtijeva značajne izračunske resurse. MoE modeli, s druge strane, koriste “sparse compute”. U umjesto jednog velikog feed-forward mreže, MoE modeli koriste nekoliko manjih mreža, nazvanih “ekspertima”. Routing mreža bira samo nekoliko eksperata za svaki token, što znači da se aktivira samo mali dio ukupnog broja parametara. Ovo je ključna razlika koja omogućuje MoE modelima da budu brži i učinkovitiji. Primjer je Mixtral 8x7B, koji ima 46.7 milijardi parametara, ali koristi samo oko 13 milijardi parametara za svaki token. (Ključne riječi: parametri, compute, inferencija, dense compute, sparse compute)

Feed-Forward Network vs. Eksperti

U Transformersima, svaki blok sadrži jednu veliku feed-forward mrežu (FFN). Svaki token prolazi kroz ovu FFN, aktivirajući sve parametre tijekom inferencije. U MoE modelima, FFN se zamjenjuje s više manjih feed-forward mreža, nazvanih “ekspertima”. Routing mreža zatim bira samo nekoliko eksperata za svaki token. Ovo omogućuje modelima da se specijaliziraju za različite aspekte podataka, što povećava njihovu ukupnu kapacitet. Razmotrimo primjer: jedan ekspert može biti dobar u prevođenju, dok drugi u pisanju kreativnih tekstova. (Ključne riječi: feed-forward mreža, eksperti, routing mreža, specijalizacija)

Parametarska Upotreba

Transformersi koriste sve parametre za svaki token, što rezultira “dense compute”. MoE modeli, iako imaju više ukupnih parametara, aktiviraju samo mali dio od njih za svaki token, što rezultira “sparse compute”. Mixtral 8x7B je izvrstan primjer: ima 46.7 milijardi parametara, ali koristi samo oko 13 milijardi za svaki token. Ovo je ključna prednost MoE modela – mogu postići veći kapacitet bez značajnog povećanja izračunskih troškova. (Ključne riječi: parametri, kapacitet, izračunski troškovi, skalabilnost)

Inferencijska Troškova

Transformersi imaju visoke inferencijske troškove zbog punog aktiviranja parametara. Za modele kao što su GPT-4 ili Llama 2 70B, potrebna su značajna računarska oprema. MoE modeli, s druge strane, imaju niže inferencijske troškove jer su samo nekoliko eksperata aktivnih za svaki token. Ovo ih čini bržima i jeftinijima za korištenje, posebno u velikim razmjerima. (Ključne riječi: inferencija, hardware, GPT-4, Llama 2)

Token Routing

Transformersi nemaju routing. Svaki token slijedi isti put kroz sve slojeve. MoE modeli koriste “učen routing” – routing mreža određuje koje eksperte token treba koristiti na temelju softmax bodova. Različiti tokeni biraju različite eksperte, što povećava specijalizaciju i ukupni kapacitet modela. (Ključne riječi: routing, softmax, tokeni, specijalizacija)

Modelni Kapacitet

Transformersi mogu povećati kapacitet dodavanjem više slojeva ili proširenjem FFN-a, što značajno povećava FLOPs (Floating Point Operations per Second). MoE modeli mogu povećati ukupni broj parametara bez značajnog povećanja izračunskih troškova po tokenu. Ovo omogućuje “veće mozove po nižoj cijeni”. (Ključne riječi: kapacitet, FLOPs, skalabilnost, mozak)

Iako MoE arhitekture nude ogromnu snagu s nižim inferencijskim troškovima, donose i određene izazove u treningu. Najčešći problem je “ekspert collapse”, gdje routing mreža konstantno bira iste eksperte, ostavljajući druge pod-trenirane. “Load imbalance” je još jedan izazov – neki eksperti mogu primiti mnogo više tokena od drugih, što dovodi do neravnomjerne učinkovitosti. Da bi se riješio ovaj problem, MoE modeli koriste tehnike kao što su “noise injection” u routing, “Top-K masking” i ograničenja kapaciteta eksperata. Ove tehnike osiguravaju da svi eksperti ostaju aktivni i uravnoteženi, ali također čine MoE sustave složenijima za treniranje u usporedbi s tradicionalnim Transformersima. (Ključne riječi: ekspert collapse, load imbalance, noise injection, Top-K masking)

The post AI Interview Series #4: Transformers vs Mixture of Experts (MoE) appeared first on MarkTechPost.

Česta pitanja (FAQ)

Pitanje: Što je to Mixture of Experts (MoE) u AI-ju?

Odgovor: MoE modeli su arhitekture za obradu prirodnog jezika koje koriste više “eksperata” umjesto jednog velikog feed-forward mreže. Routing mreža bira koji ekspert treba koristiti za svaki token, što omogućuje modelima da se specijaliziraju za različite aspekte podataka i postižu veći kapacitet uz manji izračunski trošak.

Pitanje: Zašto su MoE modeli važni?

Odgovor: MoE modeli su važni jer omogućuju razvoj AI sustava koji mogu raditi s ogromnim količinama podataka i rješavati složene probleme. Oni također nude značajne poboljšanja u brzini i učinkovitosti u usporedbi s tradicionalnim Transformersima.

Pitanje: Jesu li MoE modeli teški za treniranje?

Odgovor: Da, MoE modeli mogu biti teški za treniranje. Najčešći izazovi su “ekspert collapse” (gdje routing mreža bira samo nekoliko eksperata) i “load imbalance” (gdje neki eksperti dobivaju mnogo više tokena od drugih). Različite tehnike se koriste kako bi se riješili ovi problemi.

Pitanje: Jesu li MoE modeli zamijenit će Transformers?

Odgovor: U ovom trenutku, MoE modeli nisu zamijenili Transformers, ali postaju sve popularniji i obećavaju da će u budućnosti igrati važnu ulogu u obradi prirodnog jezika i drugim AI aplikacijama. Očekuje se da će se obje arhitekture nastaviti razvijati i nadopunjavati jedna drugom.

Pitanje: Gdje mogu pronaći više informacija o MoE modelima?

Odgovor: Mogu pronaći više informacija o MoE modelima na MarkTechPost: AI Interview Series #4: Transformers vs Mixture of Experts (MoE). Također, preporučujem da istražite relevantne publikacije i istraživanja na Google Scholaru i arXivu. (Ključne riječi: istraživanje, publikacije, Google Scholar, arXiv)

![ChatGPT 5 je stigao: brži, pametniji i dostupan svima [Besplatno] 7 chatgpt5](https://umjetnai.com/wp-content/uploads/2025/08/chatgpt5-360x180.webp)

![Mistral AI juri prema kodiranju s novim Devstral 2 i vibe CLI 17 ChatGPT 5 je stigao: brži, pametniji i dostupan svima [Besplatno]](https://umjetnai.com/wp-content/uploads/2025/08/526750221_1101661142120887_3623883531199391571_n-1-360x180.jpg)