U svijetu umjetne inteligencije, istraživači sve više teže modelima koji mogu razumjeti i slike i tekst istovremeno, pri čemu je učinkovitost obrade ključna na uređajima s ograničenim resursima. U ovom članku donosimo dubinski pregled najnovijeg doprinosa tvrtke Jina AI — Jina-VLM, vizualno-jezičnog modela sa 2.4 milijarde parametara, usmjerenog na višestrukozikovno razumijevanje dokumenata i višestruki vizualno-jezični zadatke. Ovaj model ciljano optimizira tok podataka kroz token-e, koristeći inovativnu arhitekturu koja kombinira SigLIP2 vizijsku enkoderu s jezgrenim dijelom jezika temeljenim na Qwen3. Rezultati upiru prema stanje‑um jetu najbolje otvorenih modela veličine oko 2B parametara, osobito na hitnim višetekstualno‑multijezičnim zadacima te na zadacima razumijevanja dokumenata uz ograničene Resurse. Vijest dolazi s početkom prosinca 2025., kada se u svijetu AI javno ponovno potvrđuje važnost token-efikasnosti i sposobnosti velikih multimodalnih modela da pružaju korisne odgovore na vizualna pitanja na više jezika. Navedene inovacije značajno utječu na to kako razvijamo alate za vizualno razumijevanje, istražujemo multijezične interakcije i planiramo buduće verzije koje bi mogle biti još pristupačnije na širokoj硬ware infrastrukturi.

Arhitektura: kako Jina-VLM spaja viziju i jezik

Preklopni tileovi i attention pooling konektor

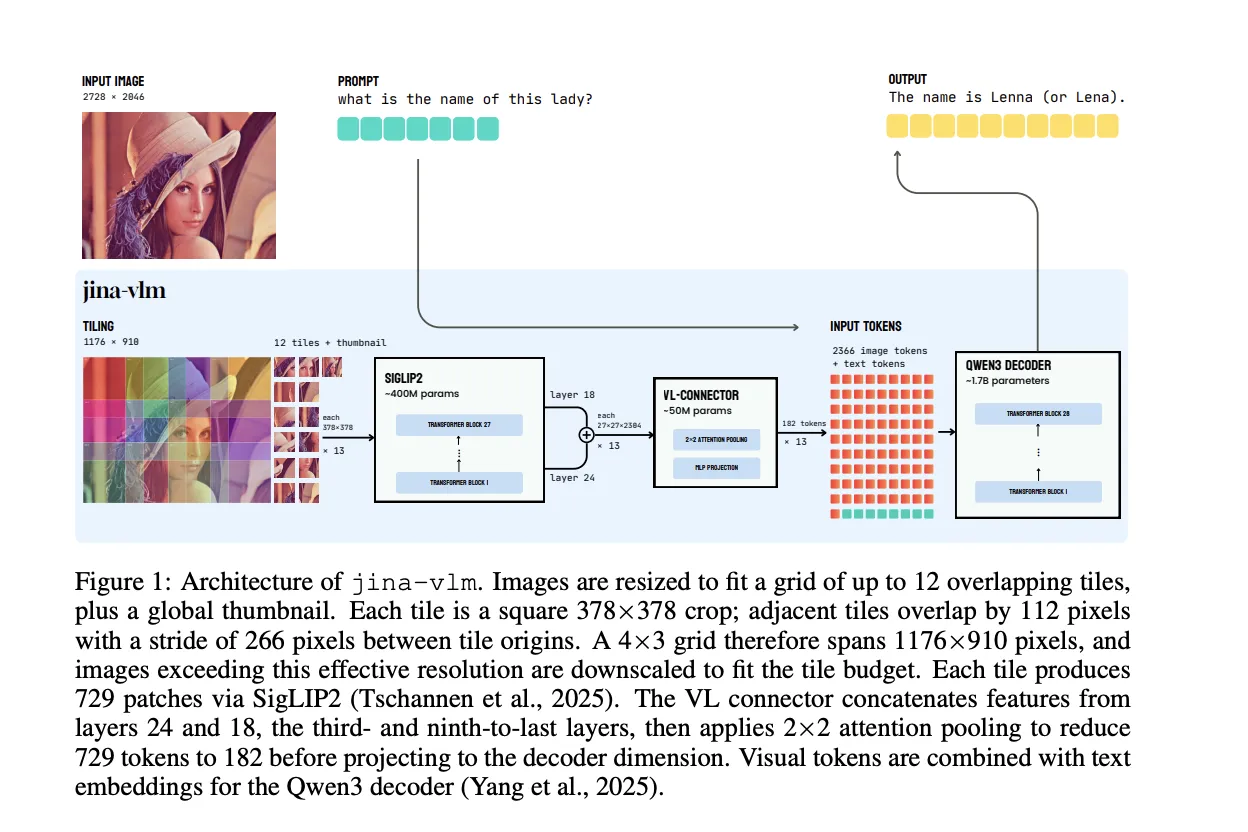

U temelju Jina‑VLM-a nalazi se standardni raspored multimodalnog modela, ali vizijska strana je posebno prilagođena radi višeg i fleksibilnijeg prijenosa podataka. Vizijska enkodera, poznata kao SigLIP2 So400M/14, brojčano prati 384 piksela po ulazu, kroz 27 slojeva Vision Transformer (ViT) s približno 400 milijuna parametara. On uzima kockice od 378×378 piksela i pretvara ih u mrežu od 27×27 patchova veličine 14×14, pri čemu svaki patch predstavlja 729 tokensa. To znači da jednako širok snop vizualnih informacija kroz model stigne kroz stotine tokena pa sve do nizova koji se koriste za semantičku obradu.

Kako bi se omogućilo obradu visokorezolucijskih slika bez rastakanja cijelog inputa u jedan kvadrat, dizajn tijela modela koristi unosnu mrežu tileova: mreža do 12 preklapajućih pločica (tiles) uz dodatni globalni sažetak u obliku thumbnail slike. Svaki tile ima veličinu 378×378 i susjedi se preklapaju za 112 piksela, dok je razmak između porijekla pločica 266 piksela. 4×3 mreža pločica omogućava efikasan rad na slikama s efektivnom rezolucijom od 1176×910 piksela prije daljnjeg smanjenja kod prilagođavanja veličine ulaza ograničenom budžetu tokena. Ovaj pristup izbjegava jednostrano „skaliranje do jedne veličine“, a umjesto toga zadržava važnu strukturnu informaciju unutar granica tiles‑a.

Srce konnektora vizualno-jezičnog (vision-language connector) nije finalni ViT sloj; umjesto toga se koriste značajke iz dva međusloja ViT modela — treći prethodni i deveti prethodni (slojevi 24 i 18) — kako bi se kombinirale visoke semantičke informacije s srednjim prostornim detaljima. Konnektor primjenjuje attention pooling preko susjednih 2×2 patchova, zbraja srednji vapitak za svaku 2×2 regiju i zatim usmjerava pažnju na cijeli spojeni završni zapis značajki. Rezultat je jedinstveni pooled token za svaku regiju, pa se ukupni broj vizualnih tokena smanjuje s 729 po tileu na 182 tokena. Time se postiže 4× kompresija vizualnih reprezentacija bez značajnog gubitka prostorne strukture. SwiGLU projekcija zatim mapira te pooled značajke na dimenziju embedinga Qwen3 jezgre.

Uz zadanu konfiguraciju od 12 tileova plus thumbnail, potpuni, naivni tok vizualnih tokena u jezični model bio bi 9.477 tokensa. Međutim, primjena attention poolinga smanjuje to na 2.366 vizualnih tokena. Potrošnja računalnih FLOPs u ViT‑u ostaje ista, no za jeznički backbone rezultat je otprilike 3,9 puta manje FLOPs prije popune, a 4 puta manja KV cache. Uključujući zajednički trošak ViT-a, ukupni FLOPs pada otprilike 2,3 puta za zadanu konfiguraciju. Ovo nije samo tehnička napomena; to znači brži start odgovora i manje memorijske potrebe, što je ključno za uređaje s ograničenim resursima ili edge‑rasponom.

Dekoder jezika koristi Qwen3‑1.7B‑Base. Model uvodi posebne token‑e za slike, označene s <im_start> i <im_end> oko sekvence tileova, uz dodatni token <im_col> kako bi se označile retke u mreži patch‑ova. Vizualni tokeni iz konektora i tekstualne embeddeing poravnavaju se i prosljeđuju Qwen3 kako bi se generirali odgovori na postavljena pitanja ili izveden logički zaključak temeljen na kontekstu.

Trening i multijezična data mix: kako su obučili model da priča više jezika

Faze treninga: usklađivanje i uputa — dvije ključne faze

Proces treniranja Jina‑VLM‑a podijeljen je u dva koraka, pri čemu su svi gradbeni dijelovi — encoder, konektor i decoder — ažurirani simultano tijekom cijelog procesa. Ukupan korpus sadrži oko 5 milijuna multimodalnih primjera i 12 milijardi tekstualnih tokena raspoređenih preko više od 30 jezika. Otprilike pola teksta dolazi na engleskom jeziku, dok ostatak pokriva visoke i srednje resursne jezike poput kineskog, arapskog, njemačkog, španjolskog, francuskog, talijanskog, japanskog i korejskog. Ova široka jezična pokrivenost omogućuje modelu da bolje razagotavlja multimodalne potrebe u različitim kontekstima.

Faza 1 ili Alignment Training fokusira se na vizualno‑jezičnu povezanost (grounding) kroz različite jezike, ali ne na izvršavanje složenih instrukcija. Primarna skupina podataka uključuje caption‑dense skupove PixmoCap i PangeaIns, koji obuhvaćaju prirodne slike, dokumente, dijagrame i infografike. U dodatku se dodaje 15 posto podataka koji sadrže samo tekst iz zajedničkog korpusa PleiAS kako bi se osiguralo da jezik ostaje snažan i bez degradacije u zadacima koji očekuju samo jezik. Konnektor koristi višu stopu učenja i kraće zagrijavanje, radi ubrzanja prilagodbe bez destabilizacije temeljnih mreža.

Faza 2 je Fine-Tuning usmjeren na uputama. Tu Jina‑VLM uči pratiti promptove za vizualno postavljanje pitanja i zaključivanje. Kombinacija uključuje modele i pristupe poput LLaVA OneVision, Cauldron, Cambrian, PangeaIns i FineVision, uz multijezične tekst‑om data podatke u Aya stilu. Prva faza treniranja provodi se s 30.000 koraka koristeći partije iz jednog izvora, a zatim se produžuje dodatnih 30.000 koraka s miješanim izvorima Podataka. Ovaj pristup stabilizira učenje u prisustvu vrlo heterogenog nadzora, čime se smanjuje rizik od neuravnoteženog prilagođavanja različitih komponenti sistema.

Podsjetnik na vremenski okvir i trendove: razvijači naglašavaju da ovakva dva‑faza strategija pomaže modelu da ostane pouzdan i u multi‑lingualnom okruženju, posebno kada se kombiniraju vizualne i tekstualne informacije. Učestalost ažurnih koraka i raznolikost skupa podataka doprinose otpornoj izvedbi u realnim scenarijima, gdje su zahtjevi za razumijevanje pročitanog sadržaja i vizualnih konteksta često kontradiktorni ili složeni. Prema planu iz 2025. godine, očekuje se daljnja ekspanzija skupa podataka i povećanje broja jezika uz održavanje visoke razine točnosti.

Performanse i implikacije: gdje Jina‑VLM staje uz najbolje među 2B‑parametarskim VLM‑ovima

Benchmarkovi i rezultati: MMMB i Multilingual MMBench na visokoj razini

Jina‑VLM postavlja visok standard među otvorenim VLM modelima veličine oko 2B parametara. Na međunarodnim multidomensionalnim testovima poput MMMB (Multilingual Multi‑Modal Benchmark) i Multilingual MMBench, model postiže vodeće rezultate u rangu s sličnim modelima i često nadmašuje konkurente s istom ili manjom veličinom parametara. Ovo je posebno značajno jer ukazuje na to da je arhitektura dizajnirana za učinkovitiju ekstrakciju semantike iz višestrukih modaliteta i jezika bez drastičnog povećanja računske složenosti. Usporedno s konkurentskim modelima, Jina‑VLM pokazuje bolji balans između točnosti odgovora i troškova izvođenja, što ga čini zanimljivom opcijom za aplikacije s ograničenim hardverom.

Ova antropomorfna sposobnost da se izvođački zadaci iz vizualnog razumijevanja i višestrukih jezika provode kroz isti zajednički tok računa i tokena, pogotovo uz dodatnu redukciju navedenih tokena zahvaljujući attention pooling konektoru, omogućava brže generiranje odgovora uz očuvanje kvalitete. U praksi to znači da sustavi temeljeni na Jina‑VLM-u mogu brže obrađivati dokumente, odgovarati na pitanja o vizualnim dijelovima prezentacija ili infografika, te razumijevati kontekst na više jezika bez potrebe za dodatnim prilagodbama modela na svakom jeziku.

Token efikasnost i računska potrošnja: koliko je to značajno u stvarnom svijetu

Jedan od ključnih izazova u radu s multimodalnim modelima ostaje linearno povećanje veličine ulaza, što vodi do sve veće potrošnje resursa. Jina‑VLM pristup s attention poolingom na tiles‑ima jasno pokazuje koliko se može postići uz značajno smanjenje prefill FLOPs i KV cache veličina. U praktičnom scenariju, smanjenje s 9.477 vizualnih tokena na 2.366 znači ne samo brže izvođenje nego i manji memorijski otisak; to je ključno za implementacije na modernim GPU‑ima i računalnim uređajima s ograničenom memorijom. U kontekstu edge‑računanja ili mobilnih uređaja, ovakva razina tokova može otvoriti vrata za korištenje multimodalnih modela u realnim aplikacijama bez potrebe za posvećenom serverskom infrastrukturom.

Dodatno, optimizacija dolazi uz kompresiju informacija bez značajne degradacije kvalitete odgovora. To znači da se visoka razina semantičke interpretacije i prostorne informacije zadržava čak i pri smanjenom broju tokena, što je ključno za rješenja koja traže brzo proticanje informacija kroz sustave za pretraživanje sadržaja ili automatizirane sustave za obradu dokumenata na više jezika.

Praktične primjene: gdje i kako biste mogli iskoristiti Jina‑VLM

Vizualno‑jezične aplikacije u dokumentnom radu i obrazovanju

Preklopne tile hipoteze i spojeni vizualno‑jezični tok savršeno odgovaraju scenarijima gdje je potrebno kvantificirati sadržaj slika i teksta istovremeno. Primjerice, u arhivama i bibliotečnim sustavima, Jina‑VLM može pomagati pri pretraživanju kroz naslovnice, tablice i grafikone te izvući ključno pitanje‑odgovor ili sažetak na višestrukim jezicima. U obrazovnom kontekstu nastavnicima i studentima može pomoći pri analiziranju stručnih materijala, gdje se slika uz tekst često upisuju u upute ili objašnjenja. Očekuje se da će ovakvi sustavi ubrzati proces filtriranja informacija i omogućiti preciznije putanje kroz kompleksne dokumente.

Višeslojno razumijevanje prezentacija i infografika

Infografike često sadrže složene vizualne layout‑e i multijezične opise. Jina‑VLM omogućava interakciju s ovakvim materijalima na način koji kombinira vizualno razumijevanje grafike s kontekstualnim informacijama iz teksta. To otvara mogućnosti za alatne setove dizajnirane za prezentacije, gdje se automatski generiraju pitanja i odgovori o ključnim dijelovima dijagrama, a ujedno se nudi i višestruki prijevod na jezik korisnika.

Multijezične potpore za digitalne asistente i chat‑bots

Kombinacija vizualne percepcije i jezične sposobnosti Jina‑VLM‑a daje značajnu prednost digitalnim asistentima koji moraju razumjeti vizualne kontekste uz tekst. Primjena može biti u korporativnim sustavima za papirologiju, gdje zaposlenici postavljaju pitanja o dokumentima ili slikama na različitim jezicima; model može automatski prevesti i dati jasne odgovore, ili čak pomoći u kreiranju sažetaka i sažetaka za menadžment timove diljem svijeta.

Prednosti i izazovi: temelj za budućnost multimodalnih modela

Prednosti

- Visoka razina multijezične podrške bez opasnosti od degradacije performansi na manjem broju jezika.

- Efikasnost tokena i smanjena potrošnja FLOPs uz očuvanje kvalitete odgovora.

- Fini tuning na način da sposoban bude za zadatke koji zahtijevaju vizualno‑jezični reasoning i odgovor na promptove.

- Smanjena memorijska potreba kroz attention pooling koji smanjuje broj vizualnih tokena, čime je lakše implementirati na uređajima s ograničenim resursima.

- Jedinost integracije vizualnih i tekstualnih signala kroz sveobuhvatan dijalog između encoder, konektora i decoder‑a.

Izazovi

- Potrebna su dodatna istraživanja kako zadržati stabilnost u scenarijima s vrlo heterogenim nadzorom i različitim jezicima.

- Specifičnosti formatiranja slika i vizualnih ulaza mogu utjecati na točnost generiranih odgovora, pa je stalna evaluacija ključna.

- Podaci o jezicima i domene treba kontinuirano proširivati kako bi podrška ostala relevantna i inkluzivna.

Zaključak: gdje nas vodi put multimodalne AI‑raščlambi

Jina‑VLM predstavlja značajan korak naprijed u konvergenciji vizualnog i jezičnog razumijevanja. Kroz inovativnu arhitekturu tile‑ova i attention pooling konektora, te kroz pažljivo dizajniran trening s fokusom na višestruke jezike, model pokazuje kako možemo postići visoke performanse uz očuvanje token‑efikasnosti i manje potrošnje računalnih resursa. To otvara put sljedećim generacijama multimodalnih alata koji su pristupačni i na uređajima s ograničenim kapacitetom, čineći primjenu umjetne inteligencije u svakodnevnim poslovnim i edukativnim kontekstima dostupnijom. Iako predstoje izazovi u izgradnji još robusnih sustava s odlučnim multimodalnim razumijevanjem, Jina‑VLM daje jasnu viziju kako to može izgledati u praksi — i što trebamo pratiti u narednim izdanjima.

Često postavljena pitanja (FAQ)

Što je Jina‑VLM? Jina‑VLM je multimodalni model koji spaja vizualno razumijevanje slika s jezičnim procesiranjem, dizajniran da radi učinkovito na uređajima s ograničenim resursima i da podrži više jezika kroz token‑efikasnu arhitekturu. Uključuje SigLIP2 vizijsku enkodere, attention pooling konektor i Qwen3 jezgreni dekoder za generiranje odgovora.

Koliko ima parametara i koliko su tokena važni? Model ima oko 2,4 milijarde parametara. Vizualni dio generira zagasito mnogo tokena, ali zahvaljujući tile pooling i 2×2 region poolingu, broj vizualnih tokena se značajno smanjuje (s 9.477 na 2.366 u standardnoj konfiguraciji), što ubrzava obradu i smanjuje memoriju.

Kako radi attention pooling? Attention pooling uzima informacije iz viših i srednjih slojeva ViT‑a, kombinira ih i kroz 2×2 susjedne regije računa srednje vrijednosti koje se zatim upotrebljavaju za stvaranje jednog pooled tokena po regiji. To omogućuje da vizualna informacija zadrži prostornu bijegu i semantiku uz manji broj tokena koji se šalju jeziku.

Koji su glavni izazovi treniranja? Najveći izazovi su usklađivanje različitih tipova nadzora (multimodalni i tekstualni) i osiguravanje učinkovitosti na mnogim jezicima uz stabilnost učenja. Uspjeh ovisi o kvaliteti i raznolikosti skupa podataka, kao i o pravilnom postavljanju tempo učenja za encoder, konektor i decoder.

Gdje se može isprobati ili vidjeti više detalja? Detal’nije tehničke informacije i eksperimentalni rezultati možete pronaći u službenim objavama i arXiv preprintu koji prate Jina‑VLM. Slike, grafovi i dodatni tehnički dijelovi često su dostupni na platformama poput Hugging Facea i istraživačkim blogovima povezanim s Jina AI.

Koje su potencijalne primjene u praksi? Primjene uključuju automatsko razumijevanje dokumenata i prezentacija, multijezičan vizualni pretraživač, asistente za grafičke materijale i obrazovne alate, te napredne sustave podrške koji mogu dati odgovore koji integriraju vizualni kontekst i više jezika, čime se ubrzava donošenje odluka i poboljšava pristupačnost sadržaja.

Koje su prednosti i ograničenja u odnosu na druge modele veličine 2B? Prednost leži u učinkovitijoj token‑efikasnosti i boljoj izvedbi na višestrukim jezicima kroz inovativnu arihitekturu tile poolinga i povezivanja. Ograničenja uključuju i dalje potrebu za značajnim računalnim resursima prilikom treniranja i evaluacije, te kontinuiranu potrebu za proširenjem skupa podataka kako bi podrška jezicima ostala ažurna i sveobuhvatna.

U mnogim aspektima, Jina‑VLM pokazuje smjer kakav industrija traži: multimodalnost koja ne žrtvuje brzinu ni točnost, sposobnost rada na mnogim jezicima i prilagodljivost različitim aplikacijama — od korporativnih alata do obrazovnih platformi. Budući da su potrebne sofisticirane vizualno‑jezične interakcije sve prisutnije, ovakvi modeli pomoći će u izgradnji raznovrsnih rješenja koja su i pametna i pristupačna korisnicima diljem svijeta.

Napomena: Sadržaj ovog članka adaptiran je za potrebe SAži AI Umjetna Inteligencija – Novosti, alati, tutoriali, savjeti na umjetnAI.com, s naglaskom na točan prijevod tehničkih detalja i jasnu, razumljivu interpretaciju. Svi tehnički podaci temelje se na javno dostupnim izvorima i objavljenim dokumentima do prosinca 2025. godine, uz prilagodbu termina i primjera kako biste lakše pratili razvoj na hrvatskom tržištu.

![Novi hibridni platforma za kvantnu simulaciju magnetizma 5 ChatGPT 5 je stigao: brži, pametniji i dostupan svima [Besplatno]](https://umjetnai.com/wp-content/uploads/2025/08/526750221_1101661142120887_3623883531199391571_n-1-350x250.jpg)

![ChatGPT 5 je stigao: brži, pametniji i dostupan svima [Besplatno] 7 chatgpt5](https://umjetnai.com/wp-content/uploads/2025/08/chatgpt5-360x180.webp)

![Novi hibridni platforma za kvantnu simulaciju magnetizma 11 ChatGPT 5 je stigao: brži, pametniji i dostupan svima [Besplatno]](https://umjetnai.com/wp-content/uploads/2025/08/526750221_1101661142120887_3623883531199391571_n-1-360x180.jpg)