Kada vaša aplikacija može komunicirati s različitim modelima velikih jezičnih modela (LLM) koji imaju različite cijene i mogućnosti, tko bi trebao odlučiti koji model će odgovoriti na svaki zahtjev? Istraživački tim Salesforcea predstavio je ‘xRouter’, sustav usmjeravanja temeljen na pozivima alata koji rješava ovu prazninu koristeći sustav usmjeravanja temeljen na pojačanju učenja, učeći kada odgovoriti lokalno, a kada pozvati vanjske modele, dok prati troškove na razini tokena.

Što je xRouter?

xRouter je sustav orkestracije temeljen na pozivima alata, izgrađen na modelu Qwen2.5-7B-Instruct kao osnovi usmjerivača. Ovaj usmjerivač je model prilagođen uputama s mogućnostima pozivanja alata koji odlučuje koji downstream model pozvati, kako ga upitati i hoće li sintetizirati ili odabrati odgovor. Implementacija koristi DAPO, Distribucijsku Politiku Optimizacije Prednosti, unutar okvira pojačanja učenja Verl, te izlaže API kompatibilan s OpenAI.

U sustavu, usmjerivač radi s više od 20 LLM alata. Ovi alati obuhvaćaju premium, standardne, budžetske i specijalizirane razine, uključujući GPT-5, GPT-4.1, GPT-5-Mini, GPT-5-Nano, o3, Kimi K2, DeepSeek-R1, Qwen3-235B varijante i GPT-OSS modele. Skup modela za prebacivanje uključuje 12 modela, među kojima su GPT-5, GPT-5-Mini, GPT-5-Nano, GPT-4o, GPT-4.1, o3, o3-Pro, o4-Mini, GPT-OSS-120B, GPT-OSS-20B i dvije varijante Gemini-2.5.

Nagrade svjesne troškova i uspješno usmjeravanje

Usmjeravanje se postavlja kao problem pojačanja učenja. Za svaku epizodu, nagrada kombinira binarni signal uspjeha i kaznu za troškove. Istraživački tim definira nagradu koja daje fiksni bonus kada je konačni odgovor točan, a zatim oduzima iznos proporcionalan ukupnim normaliziranim troškovima svih poziva modela. Ako je odgovor netočan, nagrada je nula bez obzira na to koliko je jeftin bio.

Prema stranici s modelima, nagrada = kvaliteta − λ × normalizirani_trošak, gdje je λ koeficijent kazne za troškove. Epizode s neuspjesima zapravo imaju nultu kvalitetu. Ovaj ‘uspjeh ograničen, troškovno oblikovan’ cilj prisiljava usmjerivač da prvo postigne točnost, a zatim optimizira troškove među uspješnim strategijama. U praksi, obuka koristi 3 postavke kazne za troškove, koje proizvode varijante xRouter-7B-1, xRouter-7B-2 i xRouter-7B-3.

Podaci o obuci i dizajn signala

Podaci za obuku xRoutera dolaze iz Reasoning360, koji uključuje matematičke, programske i opće zadatke razmišljanja s procjenama težine izvedenim iz snažnog referentnog modela, Qwen3-32B. Istraživački tim stratificira uzorke u lagane, srednje i teške kategorije, te dodaje jednostavnije razgovore, pretraživanje i faktualna pitanja kako bi poučio usmjerivač kada može izravno odgovoriti bez delegiranja. Svaki uzorak uključuje opise i cijene modela iz različitih razina. Sustav također osvježava katalog modela i perturbira troškove kako bi izbjegao prekomjerno prilagođavanje statičnoj tablici cijena.

Neuspješni putevi, poput netočnih odgovora od skupih modela ili nepotrebnih poziva kada je usmjerivač mogao sam odgovoriti, i dalje snose pune troškove i primaju nultu nagradu. Ovo stvara čisti signal učenja, gdje točnost ograničava nagradu, a trošak oblikuje politiku usmjeravanja.

Kako usmjerivač ponaša u vremenu inferencije?

Usmjerivač podržava tri načina izvršavanja. Može izravno odgovoriti iz osnovnog modela bez pozivanja alata. Može pozvati jedan ili više downstream modela, a zatim sintetizirati odgovor koristeći vlastito razmišljanje o njihovim ishodima. Također može pozvati downstream modele i koristiti poseban alat select_response za odabir jednog od odgovora kao konačnog odgovora. Ovi načini implementirani su kroz funkcijske pozive u sučelju sličnom OpenAI, koje orkestracijski motor izvršava putem LiteLLM i SGLang.

Empirijski, obučeni xRouter primjeri koriste mješavinu izravnih i sintetiziranih odgovora. Gotovi usmjerivači poput GPT-4o, GPT-4.1, GPT-5, Qwen2.5-7B i Qwen3-8B obično odgovaraju izravno većinu vremena, čak i kada su upute da prebacuju kada su nesigurni. Ovo je važna razlika u ponašanju i objašnjava dio dobitka u učinkovitosti.

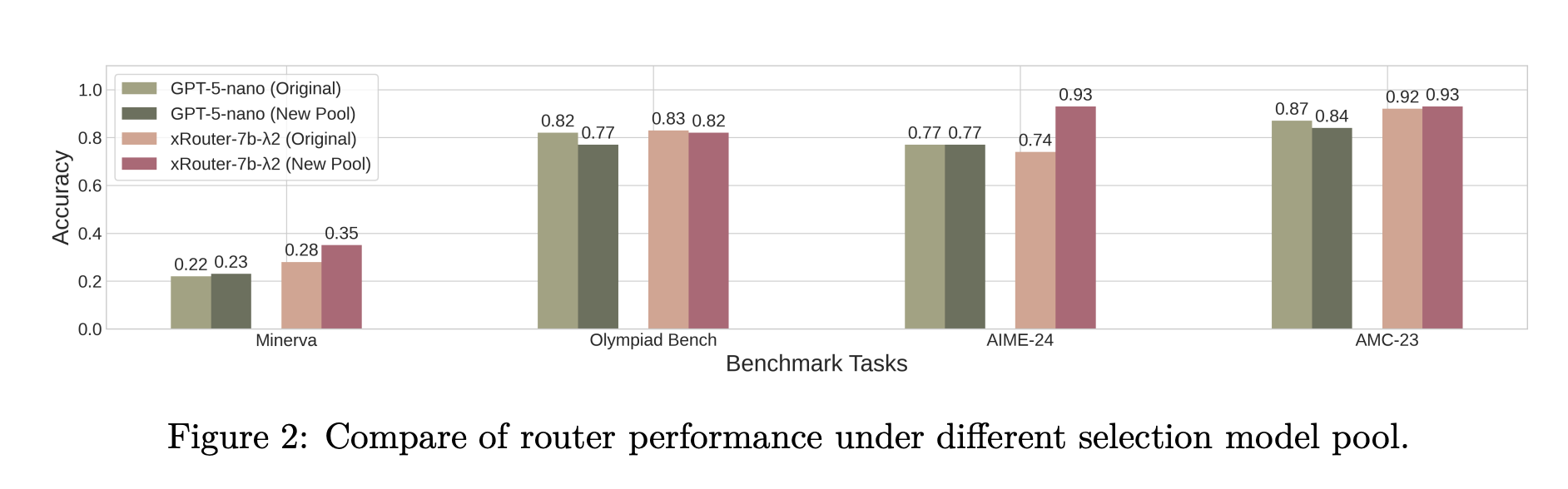

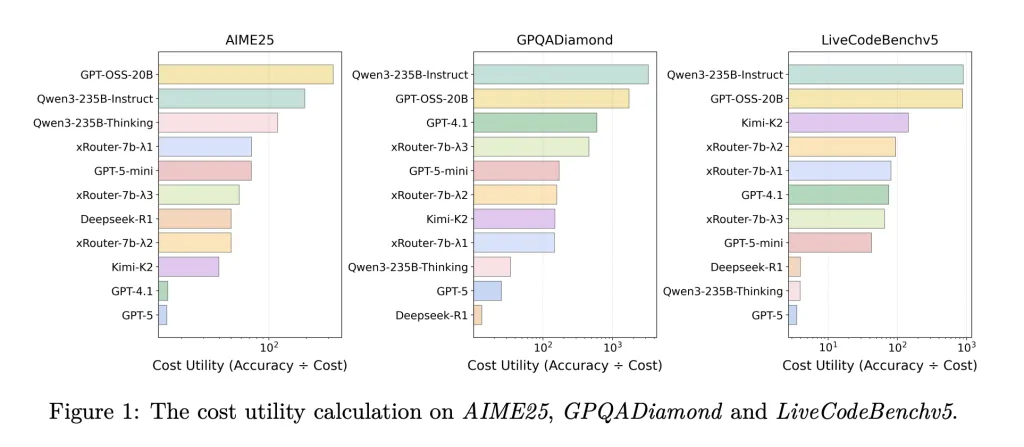

Kvantitativni rezultati i troškovna utilitarnost

Na statičkim osnovama usmjeravanja kroz Minerva, MATH-500, Olympiad Bench, AIME-24, AMC-23, Codeforces, Code-Contests i Human-EvalPlus, varijante xRouter-7B dosljedno poboljšavaju točnost u usporedbi s korištenjem istog osnovnog modela kao neobučeni usmjerivač. Na primjer, xRouter-7B-2 postiže gotovo GPT-5 točnost na Olympiad Benchu dok koristi oko jednu osminu troška evaluacije GPT-5.

U sustavnoj usporedbi na LiveCodeBenchv5, GPQADiamond, AIME25, MT-Bench, IFEval i LiveBench, xRouter-7B-3 postiže najvišu prosječnu točnost na LiveCodeBenchv5, što dodatno potvrđuje njegovu učinkovitost.

Zaključak

Salesforceov xRouter predstavlja značajan napredak u upravljanju LLM-ovima, omogućujući optimizaciju troškova i poboljšanje točnosti odgovora. Ovaj sustav ne samo da poboljšava učinkovitost već i pruža korisnicima priliku da dobiju najbolje moguće odgovore bez obzira na troškove. S obzirom na sve veći broj dostupnih LLM-ova, ovakvi alati postaju ključni za uspješno upravljanje resursima i postizanje optimalnih rezultata.

Najčešća pitanja (FAQ)

Što je xRouter?

xRouter je sustav usmjeravanja temeljen na pojačanju učenja koji optimizira odabir LLM-a za odgovaranje na korisničke zahtjeve, uzimajući u obzir troškove i točnost.

Kako funkcionira xRouter?

xRouter koristi različite modele LLM-a i odlučuje koji će model pozvati na temelju troškova i kvalitete odgovora, koristeći pojačanje učenja za optimizaciju svojih odluka.

Koje su prednosti korištenja xRoutera?

Prednosti uključuju smanjenje troškova, povećanje točnosti odgovora i mogućnost korištenja različitih modela prema potrebama korisnika.

Kako se obučava xRouter?

xRouter se obučava koristeći podatke iz Reasoning360, koji uključuju različite zadatke razmišljanja, a koristi i nagrade i kazne za optimizaciju svojih odluka.

Kako se uspoređuje s drugim modelima?

xRouter pokazuje poboljšanu točnost i smanjene troškove u usporedbi s drugim modelima, kao što su GPT-5, što ga čini učinkovitijim rješenjem za upravljanje LLM-ovima.

![ChatGPT 5 je stigao: brži, pametniji i dostupan svima [Besplatno] 7 chatgpt5](https://umjetnai.com/wp-content/uploads/2025/08/chatgpt5-360x180.webp)

![Mistral AI juri prema kodiranju s novim Devstral 2 i vibe CLI 17 ChatGPT 5 je stigao: brži, pametniji i dostupan svima [Besplatno]](https://umjetnai.com/wp-content/uploads/2025/08/526750221_1101661142120887_3623883531199391571_n-1-360x180.jpg)